(iThome鐵人賽系列書)

2024/08/10

Language

Traditional Chinese

File format

PDF (29MB), fit in large screen and Pubook

Pages

396

ISBN

9786263339828

Series

iThome鐵人賽系列書

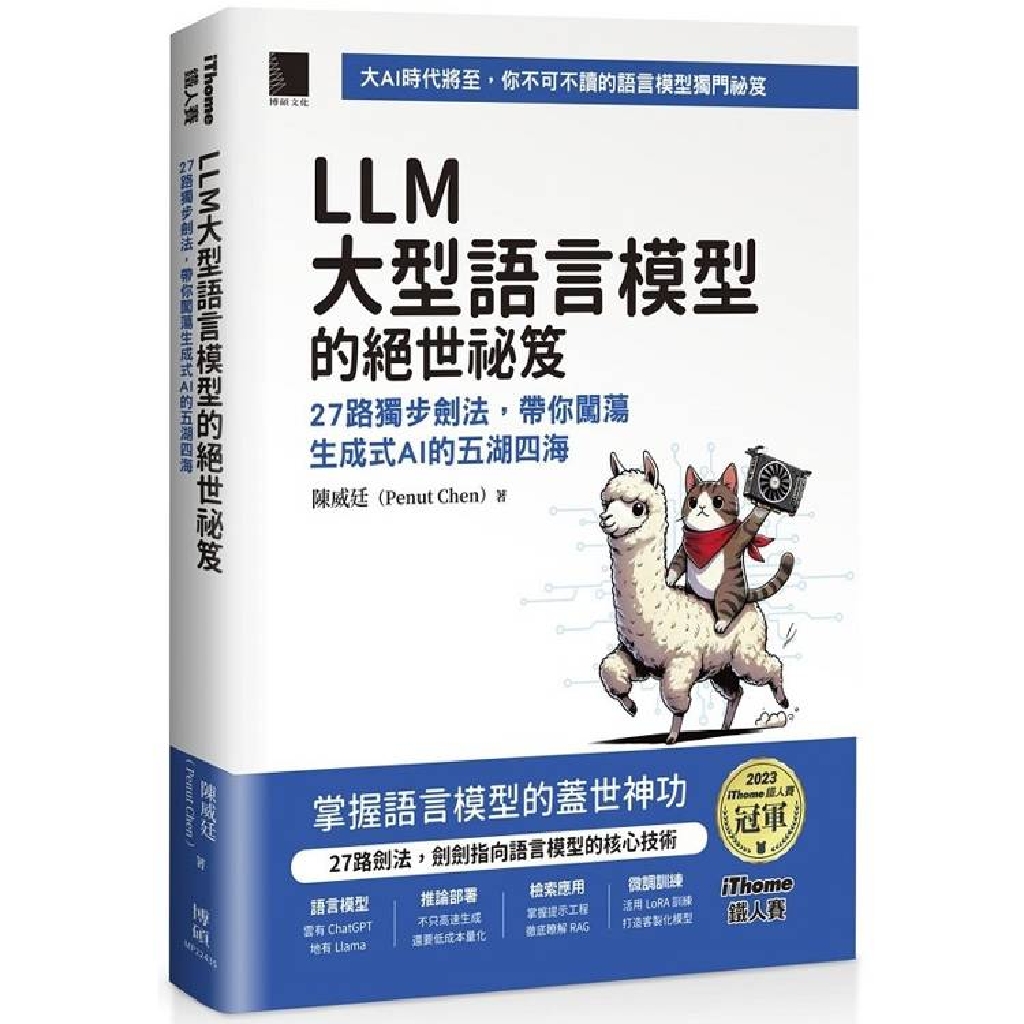

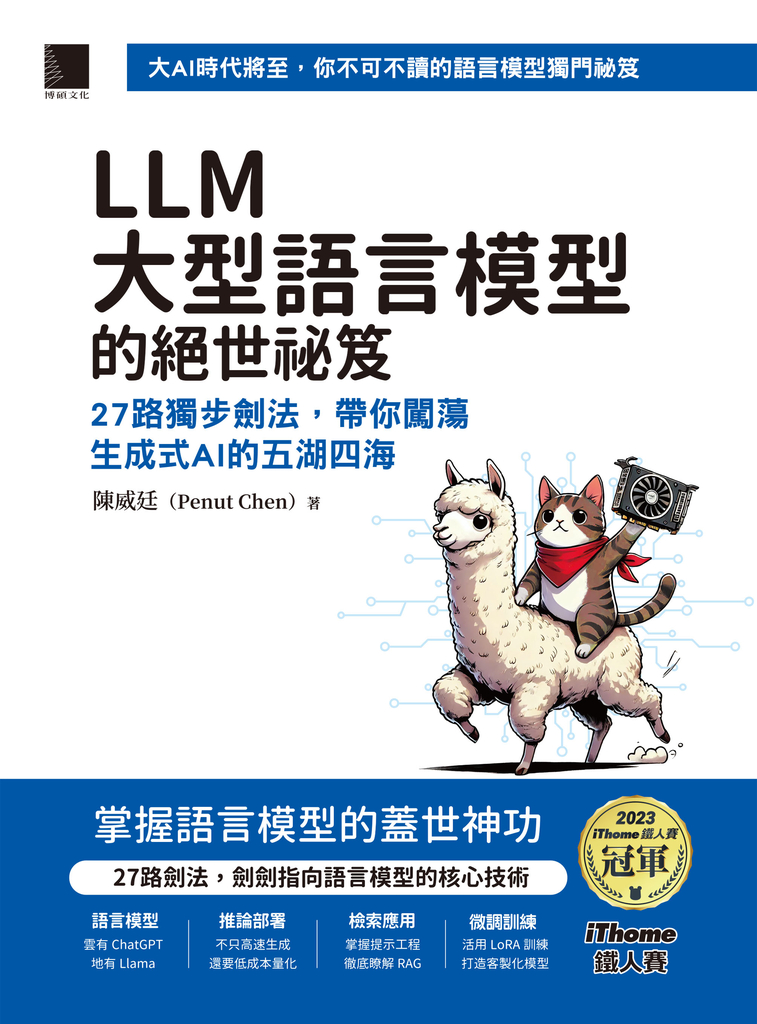

大AI時代將至,你不可不讀的語言模型獨門祕笈

帶你輕鬆遨遊生成式AI的世界!

本書內容改編自第15屆iThome鐵人賽AI & Data組冠軍系列文章《LLM學習筆記》,這是個生成式AI崛起的年代,其中又以ChatGPT為首的大型語言模型(Large-Scale Language Model, LLM)們最為令人驚豔,但是每當我們提到LLM時,腦中浮現的可能都是一些參數量龐大、架構絢麗又複雜、沒有個幾千幾百張GPU跑不動的超複雜數學模型!

其實掌握語言模型並沒有那麼困難,本書介紹了許多在建立LLM相關應用時會使用到的技術:在雲端可以透過簡單的ChatGPT API打造有趣的塔羅占卜應用;在地端有 Hugging Face TGI、vLLM、llama.cpp等推論框架,就算只有單顯卡也能高速部署、輕鬆玩轉各式各樣Open Source的LLM。透過多種量化技術減少記憶體開銷,小顯卡也能推動大模型!還有許多文本檢索的技巧,帶你一步步構築出RAG實務應用。最後當然少不了,透過LoRA訓練手法輕鬆打造專屬於你的客製化語言模型!

筆者根據自身的實務經驗,介紹深入但是易懂的理論,使用簡單但是務實的技術,帶領大家瞭解如何在低成本、低資源的環境中打造LLM相關應用。無論你是求知若渴的研究員,或是躍躍欲試的工程師,都能從本書中得到滿滿的收穫!

重點摘要:

✦ 語言模型

雲有ChatGPT,地有Llama

✦ 推論部署

不只高速生成,還要低成本量化

✦ 檢索應用

掌握提示工程,徹底瞭解RAG

✦ 微調訓練

活用LoRA訓練,打造客製化模型

本書可以學到哪些知識:

● 量化:減少模型的顯示卡記憶體使用量。

● 部署:將模型以後端服務的形式進行部署。

● 推論:如何達到更快速的文字生成速度。

● 微調:調整訓練模型的權重以符合應用需求。

● 檢索:從外部知識庫搜尋相關資料輔助模型生成。

● 應用:結合以上技術搭建出一個實際的應用。

目標讀者:

.對LLM充滿好奇的讀者

.想要嘗試涉足AI領域的初學者

.想要簡單瞭解LLM相關理論的領導者

.想要深入學習LLM相關技術的工程師

.想要一本AI相關的書籍,又不想要內容太深澀難懂的休閒玩家

.擁有自己的機器,想要實際動手玩轉語言模型的深度玩家

.大AI時代來臨,手邊卻還沒有一本AI相關書籍的朋友

【專業推薦】

本書在鐵人賽文章的基礎上增加了更多內容。除了介紹各種常見的語言模型及其使用方式外,還補充了許多細節和實作部分,書中的程式碼附有連結至GitHub供參考。本書內容涵蓋了ChatGPT的各項使用、延伸應用及工具,還有各種神經網路語言模型的說明,例如Transformer、LLaMa,並且介紹了台灣常見的大型語言模型,如Breeze、Taiwan LLM、TAIDE等。當然,書中也詳細指導如何透過開放源碼的語言模型來建立並訓練自己的AI應用。感謝作者花費大量時間編寫此書,清楚地整理及介紹了大型語言模型。對於想學習大型語言模型並打造屬於自己AI的讀者,相信本書可以讓你事半功倍。

──── 徐千洋|台灣駭客年會創辦人、CYBAVO共同創辦人

威廷在求學時期就是個興趣廣泛的人,一聽到新觀念,會馬上深入研究。頗有心得時,還會將筆記分享給大家,是那種資工系最歡迎的自動自發的學生。長期在網路世界打滾的他也深諳網路語彙,由他來寫這本書真是再適合不過了。這本書有理論、有程式,有實作運用演練,也有趨勢新知的分享。內容論述深入淺出,範例鮮明。整本書居然涵蓋了二十多種主題,簡直物超所值,收穫滿滿!期待這本書能點燃許多人心中對LLM的好奇心,並成為踏入AI世界的最大支援火力!

──── 林川傑|國立臺灣海洋大學資訊工程學系 助理教授

不管你是什麼原因想要認識AI:是正要開始認識AI的新手小白,或是突然接到一個AI專案導入並且要馬上有一番通盤概念的苦命工程師,都非常適合閱讀這本書。本書中前半的篇章淺顯易懂,讓完全的新手也能夠輕易讀懂難啃的專業術語,後面的篇章有很多實作的專案練習;而我作為一名本科仔,依然可以透過這些實作加深印象,也補足了離校至今的新知。書中同時也穿插了許多情境式的帶入及豐富的額外小知識補充,再搭配詳細的文獻資料可供延伸學習以及深入解析。相信這本書一定可以讓大家更容易進入AI的世界,成為LLM大師指日可待!

──── 林俊廷 JT Lin|iThome鐵人賽戰友、NZXT軟體工程師、花生大師追隨者

帶你輕鬆遨遊生成式AI的世界!

本書內容改編自第15屆iThome鐵人賽AI & Data組冠軍系列文章《LLM學習筆記》,這是個生成式AI崛起的年代,其中又以ChatGPT為首的大型語言模型(Large-Scale Language Model, LLM)們最為令人驚豔,但是每當我們提到LLM時,腦中浮現的可能都是一些參數量龐大、架構絢麗又複雜、沒有個幾千幾百張GPU跑不動的超複雜數學模型!

其實掌握語言模型並沒有那麼困難,本書介紹了許多在建立LLM相關應用時會使用到的技術:在雲端可以透過簡單的ChatGPT API打造有趣的塔羅占卜應用;在地端有 Hugging Face TGI、vLLM、llama.cpp等推論框架,就算只有單顯卡也能高速部署、輕鬆玩轉各式各樣Open Source的LLM。透過多種量化技術減少記憶體開銷,小顯卡也能推動大模型!還有許多文本檢索的技巧,帶你一步步構築出RAG實務應用。最後當然少不了,透過LoRA訓練手法輕鬆打造專屬於你的客製化語言模型!

筆者根據自身的實務經驗,介紹深入但是易懂的理論,使用簡單但是務實的技術,帶領大家瞭解如何在低成本、低資源的環境中打造LLM相關應用。無論你是求知若渴的研究員,或是躍躍欲試的工程師,都能從本書中得到滿滿的收穫!

重點摘要:

✦ 語言模型

雲有ChatGPT,地有Llama

✦ 推論部署

不只高速生成,還要低成本量化

✦ 檢索應用

掌握提示工程,徹底瞭解RAG

✦ 微調訓練

活用LoRA訓練,打造客製化模型

本書可以學到哪些知識:

● 量化:減少模型的顯示卡記憶體使用量。

● 部署:將模型以後端服務的形式進行部署。

● 推論:如何達到更快速的文字生成速度。

● 微調:調整訓練模型的權重以符合應用需求。

● 檢索:從外部知識庫搜尋相關資料輔助模型生成。

● 應用:結合以上技術搭建出一個實際的應用。

目標讀者:

.對LLM充滿好奇的讀者

.想要嘗試涉足AI領域的初學者

.想要簡單瞭解LLM相關理論的領導者

.想要深入學習LLM相關技術的工程師

.想要一本AI相關的書籍,又不想要內容太深澀難懂的休閒玩家

.擁有自己的機器,想要實際動手玩轉語言模型的深度玩家

.大AI時代來臨,手邊卻還沒有一本AI相關書籍的朋友

【專業推薦】

本書在鐵人賽文章的基礎上增加了更多內容。除了介紹各種常見的語言模型及其使用方式外,還補充了許多細節和實作部分,書中的程式碼附有連結至GitHub供參考。本書內容涵蓋了ChatGPT的各項使用、延伸應用及工具,還有各種神經網路語言模型的說明,例如Transformer、LLaMa,並且介紹了台灣常見的大型語言模型,如Breeze、Taiwan LLM、TAIDE等。當然,書中也詳細指導如何透過開放源碼的語言模型來建立並訓練自己的AI應用。感謝作者花費大量時間編寫此書,清楚地整理及介紹了大型語言模型。對於想學習大型語言模型並打造屬於自己AI的讀者,相信本書可以讓你事半功倍。

──── 徐千洋|台灣駭客年會創辦人、CYBAVO共同創辦人

威廷在求學時期就是個興趣廣泛的人,一聽到新觀念,會馬上深入研究。頗有心得時,還會將筆記分享給大家,是那種資工系最歡迎的自動自發的學生。長期在網路世界打滾的他也深諳網路語彙,由他來寫這本書真是再適合不過了。這本書有理論、有程式,有實作運用演練,也有趨勢新知的分享。內容論述深入淺出,範例鮮明。整本書居然涵蓋了二十多種主題,簡直物超所值,收穫滿滿!期待這本書能點燃許多人心中對LLM的好奇心,並成為踏入AI世界的最大支援火力!

──── 林川傑|國立臺灣海洋大學資訊工程學系 助理教授

不管你是什麼原因想要認識AI:是正要開始認識AI的新手小白,或是突然接到一個AI專案導入並且要馬上有一番通盤概念的苦命工程師,都非常適合閱讀這本書。本書中前半的篇章淺顯易懂,讓完全的新手也能夠輕易讀懂難啃的專業術語,後面的篇章有很多實作的專案練習;而我作為一名本科仔,依然可以透過這些實作加深印象,也補足了離校至今的新知。書中同時也穿插了許多情境式的帶入及豐富的額外小知識補充,再搭配詳細的文獻資料可供延伸學習以及深入解析。相信這本書一定可以讓大家更容易進入AI的世界,成為LLM大師指日可待!

──── 林俊廷 JT Lin|iThome鐵人賽戰友、NZXT軟體工程師、花生大師追隨者

Ch 01 語言模型能吃嗎?

Ch 02 神經網路語言模型

Ch 03 ChatGPT

Ch 04 OpenAI API

Ch 05 AI實戰應用:貓貓塔羅

Ch 06 ChatGPT的挑戰者們

Ch 07 ChatGPT相關應用

Ch 08 檢索與生成

Ch 09 走訪LLM訓練流程

Ch 10 建立開發環境

Ch 11 擁抱開源的微笑Hugging Face Transformers

Ch 12 數若繁星的語言模型們

Ch 13 語言模型也懂寫程式!

Ch 14 貧民英雄,量化超人

Ch 15 ggml & llama.cpp

Ch 16 Text Generation Inference

Ch 17 vLLM & Paged Attention

Ch 18 情境學習In-Context Learning

Ch 19 再訪檢索模型

Ch 20 任務導向聊天機器人

Ch 21 LangChain

Ch 22 微調語言模型DIY!

Ch 23 PEFT & LoRA

Ch 24 永遠不夠長!

Ch 25 資料何其多,硬碟何其小

Ch 26 授權條款與社會責任

Ch 27 學海無涯,學無止境

Ch 02 神經網路語言模型

Ch 03 ChatGPT

Ch 04 OpenAI API

Ch 05 AI實戰應用:貓貓塔羅

Ch 06 ChatGPT的挑戰者們

Ch 07 ChatGPT相關應用

Ch 08 檢索與生成

Ch 09 走訪LLM訓練流程

Ch 10 建立開發環境

Ch 11 擁抱開源的微笑Hugging Face Transformers

Ch 12 數若繁星的語言模型們

Ch 13 語言模型也懂寫程式!

Ch 14 貧民英雄,量化超人

Ch 15 ggml & llama.cpp

Ch 16 Text Generation Inference

Ch 17 vLLM & Paged Attention

Ch 18 情境學習In-Context Learning

Ch 19 再訪檢索模型

Ch 20 任務導向聊天機器人

Ch 21 LangChain

Ch 22 微調語言模型DIY!

Ch 23 PEFT & LoRA

Ch 24 永遠不夠長!

Ch 25 資料何其多,硬碟何其小

Ch 26 授權條款與社會責任

Ch 27 學海無涯,學無止境

陳威廷(Penut Chen)

在新店角落默默無聞a樂天派技術宅,不只喜歡寫程式,也喜歡跟大家分享技術,除了在網路上發表教學文章、範例專案以外,也主持過技術分享的讀書會。主要的專業在自然語言處理領域,原本從一個乏人問津的NLP實驗室畢業,沒想到遇上了ChatGPT帶來的生成式AI熱潮,一夜之間大家對LLM興趣水漲船高,然而我的薪水身價卻依然四平八穩,於是決定到iThome鐵人賽上抖出我的渾身解數,很榮幸的獲得了AI & Data組的冠軍。

在成長的路上受到許多師長與前輩的開導,深深感受到知識與學習對於一個人是如此重要,在我的心中相當尊敬這些撰寫知識、傳播知識的人們,本著「取之於社會,用之於社會」的心情,來向大家分享我對這個領域的理解與熱忱!

在新店角落默默無聞a樂天派技術宅,不只喜歡寫程式,也喜歡跟大家分享技術,除了在網路上發表教學文章、範例專案以外,也主持過技術分享的讀書會。主要的專業在自然語言處理領域,原本從一個乏人問津的NLP實驗室畢業,沒想到遇上了ChatGPT帶來的生成式AI熱潮,一夜之間大家對LLM興趣水漲船高,然而我的薪水身價卻依然四平八穩,於是決定到iThome鐵人賽上抖出我的渾身解數,很榮幸的獲得了AI & Data組的冠軍。

在成長的路上受到許多師長與前輩的開導,深深感受到知識與學習對於一個人是如此重要,在我的心中相當尊敬這些撰寫知識、傳播知識的人們,本著「取之於社會,用之於社會」的心情,來向大家分享我對這個領域的理解與熱忱!

Details

Review

0 ratings

1 stars

0%

2 stars

0%

3 stars

0%

4 stars

0%

5 stars

0%

Write a review

Eligible to write reviews after purchasing products or add to Library